1 企業における生成AI利活用の状況

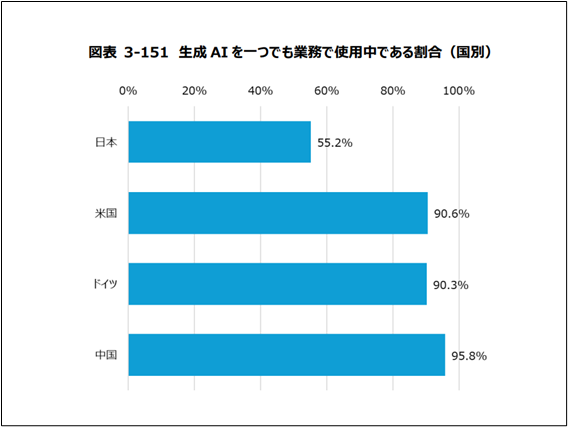

生成AIの登場以降、事業領域におけるAIサービスの利活用は年々拡大していますが、2025年3月に公表された総務省の調査結果資料によれば、下記の図のとおり、日本国内で何らかの業務で生成AIを利用していると回答した事業者の割合は55.2%にとどまり、米国の90.6%、ドイツの90.3%、中国の95.8%と比べて未だ低い水準にあるといえます。

2 AI利活⽤における⺠事責任

AIシステム・サービスの導入や開発を躊躇させる要因の一つとして、AIの有するリスクが顕在化し事故が発生した際の民事責任のあり方について、AIの自律性やブラックボックス性を踏まえてどのように解釈適用を行うべきか、裁判例や統一的な見解がなく、責任の所在が不明瞭であることが指摘されています。

このような状況を踏まえて、経産省にて「AI利活用における民事責任の在り方に関する研究会」(以下「本研究会」といいます。)が設置され、AIを用いたサービスやシステムが事故に寄与した仮想事例を題材に、不法行為法及び製造物責任法の観点から解釈適用上の論点及び考え方の整理が行われることになりました。

本稿では、事務局説明資料に基づき、2025年8月19日に開催された本研究会の第1回会議(以下「本会議」といいます。)での整理の概要等を紹介します。

3 検討対象ユースケース

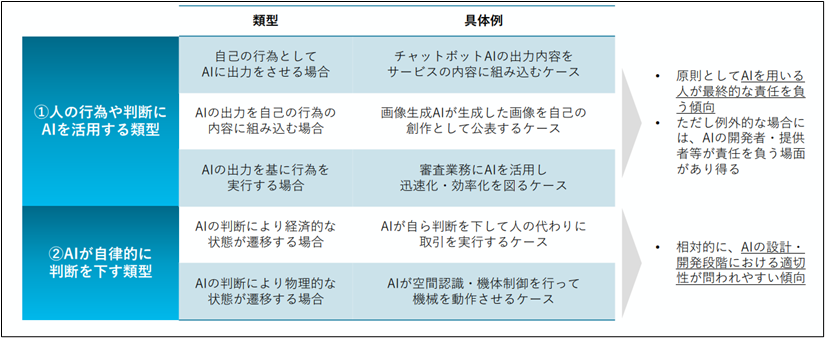

まず、本研究会では、下記の表のとおり、検討対象となるユースケースを「人の行為や判断にAIを活用する類型」と「AIが自立的に判断を下す類型」の2つに大別し、それぞれの類型における代表的な想定事例に関する検討を通じて、一定の汎用的な考え方や判断枠組みを抽出することを目指すものとしています。

ここで特筆すべき点として、「人の行為や判断にAIを活用する類型」においては、原則としてAIを用いる人が最終的な責任を負う傾向にあり、AIの開発・提供者等が責任を負う場面は例外的とされているのに対し、「AIが自立的に判断を下す類型」では、相対的にAIの設計・開発段階における適切性が問われやすい傾向にあると整理されている点が挙げられます。

4 事例検討

次に、本会議では、不法⾏為法のうち過失責任について、2つの想定事例をもとに、事業者が業務で判断補助AIを用いていた場合において、当該事業者やAI開発・提供事業者がどのような注意義務(責任)を負うのか、またその注意義務の内容が「通常業務」と「専門業務」とで異なり得るのかといった点が検討されました。

以下、それぞれについてみていきます。

想定事例1:判断補助AI(通常業務)

本研究会で示された想定事例1の概要は以下のとおりです。

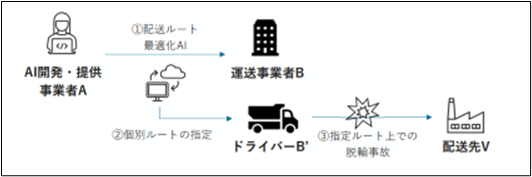

運送事業者Bは、AI開発・提供事業者Aが提供する配送ルート最適化AIシステム(以下「本AIシステム」といいます。)を使用しており、従業員である各ドライバーに対し、原則として本AIシステムが出⼒したルートに従って日々の配送ルートを決定するよう指示していた。

ある日、運送事業者Bの従業員であるドライバーB’が本AIシステムを使用したところ、同システムは実際には幅員が狭く配送車両の運行に適さない悪路を「最適ルート」と表示した。B’が本AIシステムの出力に従い当該ルートを走行したところ、結果として運行のための十分なスペースがなく脱輪してしまい、その際の衝撃で配送先V社の荷物が損壊し、Vは代替品の調達等のために損害を被った。

運送事業者B及びドライバーB’の責任

このようなケースでは、本AIシステムはあくまで運行上の判断の補助ツールと位置づけられ、B’は、本AIシステムの出力とは独立に、Vの荷物を損壊しないように安全な走行経路を選択する義務を負い、当該義務違反が認められる場合にはBʼ及びB が責任を負うと整理されています。

AI開発・提供事業者Aの責任

以下の考慮から、Aが何らかの注意義務を負う場面は限定的であり、第三者(V)との関係では、原則としてAIに基づき判断を⾏った利⽤者(BʼないしB)が責任を負うと整理されています。

✓ Aは、契約の相⼿⽅であるBとの関係ではAIの品質や性能に関する契約上の義務を負うものの、このような契約上の義務は契約外の第三者に対して負うものではない

✓ 最終的に判断を下したAI利⽤者の⾏為について責任を負わないのが原則

✓ AI利⽤者にはAIを⽤いていない場合と同⽔準の義務が認められることから、重ねてAに責任を認めずとも被害者救済に悖ることはない

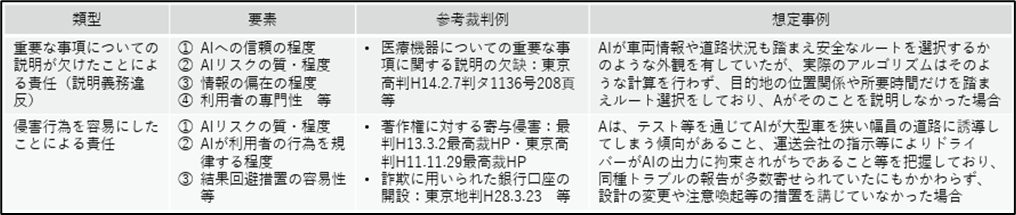

ただし、下記の表のように❶重要な事項についての説明が欠けていた場合や、❷侵害行為を容易にしたと認められる場合には、Bとの共同不法行為が問題となり得るとしています。

なお、Aが不法行為責任を負わないとしても、Bとの関係では、契約で合意された品質に満たないAIサービスの提供によって事故が生じた場合には、Bに対し契約責任を負い得ることになります。

想定事例2:判断補助AI(専⾨業務)

本研究会で示された想定事例2の概要は以下のとおりです。

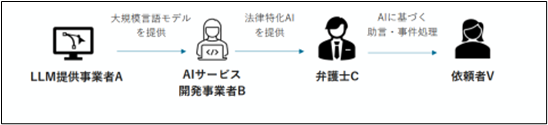

AIサービス開発事業者Bは、LLM提供事業者Aが提供している汎⽤的な⼤規模⾔語モデルをファインチューニングし、弁護⼠業務を補助するチャットボット形式のAIサービス(以下「本AIサービス」という。)を構築・提供しており、弁護⼠Cは、本AIサービスを⾃⼰の業務に導⼊していた。

Cは、依頼者Vから相談を受けた紛争案件について、本AIサービスを利用したところ、Vの⽴場を裏付ける裁判例が複数存在し、主張が認められる可能性は⾼いという出力が得られた。

Cはかかる出⼒を信頼し、和解を検討せず、Vの利益の最⼤化を図る⽅針を⽴てた。しかし実際には、本AIサービスは実在しない架空の裁判例を複数引⽤してVの⽴場を⽀える根拠としており、実存する裁判例としてはVの主張に否定的なものが⼤多数を占めており、最終的に、裁判所においてVの主張は全⾯的に棄却され、Vは訴訟追⾏等に要した⼿続費⽤等の損害を被った。

弁護士Cの責任

基本的な考え方は想定事例1と同様であり、本AIサービスはあくまで判断の補助ツールと位置づけられ、Cは、本AIサービスの出力に独立して、Vとの間の委任契約に基づき、事件処理にあたり重⼤な過誤によってVに経済的損失を⽣ぜしめないようにする注意義務を負うと整理されています。

特筆すべき点として、本ケースでは弁護⼠業務を補助するAIサービスが問題となっていますが、弁護士法72条では、弁護⼠以外の者が⼀定の法律事務を⾏ってはならない旨が規定されており、法律事務に関する判断は弁護⼠の職責においてのみ⾏うべきことが前提となっているところ、こうした規制に代表されるように、専⾨性の高い業務では、AI を利⽤する者が⾃らの独⽴した判断を下すことが求められていることが指摘されています。

LLM提供事業者A及びAIサービス開発時業者Bの責任

基本的な考え方は想定事例1と同様であり、第三者(V)との関係では、原則としてAIに基づき判断を⾏った利⽤者(C)が責任を負うと整理されています。

特筆すべき点として、例外的なケースではAないしBの❶重要な事項についての説明が欠けていたことによる責任(説明義務違反)や、❷侵害行為を容易にしたことによる責任が成立し得る余地があるという点では想定事例1と同様であるものの、専門性の高い業務で用いられるAIは、最終的に利用者である専門家が独立した正確な判断を下すべきことが前提となっていることなどから、「専門業務」の領域ではAI開発・提供事業者の責任の範囲は「通常業務」に比して狭まり得ることが示唆されています。

「専門業務」の判断基準

では、どのような業務が「専門業務」と扱われるのでしょうか。

この点、「通常業務」と「専門業務」との明確な区分は存在しないものの、①業務の性質・難易度、②判断に誤りがあった場合のリスクの性質・程度、③資格制度の有無といった事情を考慮し、⼈がAIの出⼒にかかわらず独⽴した正確な判断を下すことが求められる業務は、「専⾨業務」と評価される可能性が⾼まるとの見解が示されています。

5 本会議のまとめ

本会議では、判断補助AIが事故に寄与したケースにおいては、原則としては当該AIを利用する事業者側が被害者に対し責任を負うことになり、AI開発・提供事業者側が責任を負うのは例外的なケースに限られ、とりわけ専門性の高い業務においてはAI開発・提供事業者の責任の範囲がより限定され得る、との整理が示されました。

6 判断補助型AIに関する企業のリスク管理:第1回会議を踏まえて

以上、本稿では「AI利活用における民事責任の在り方に関する研究会」の第1回会議について取り上げました。

AI利活用における民事責任の在り方に関する議論はまだ始まったばかりであり、今後の議論の進展も注視する必要があります。しかし、本会議における整理は、事業者にて判断補助型AIを利活用する際に直面するリーガルリスク及びその対応を検討する上で、一つの指針となり得る考え方を提示したものといえるのではないでしょうか。

すなわち、本会議における整理を前提とするのであれば、判断補助型AIが誤った回答を出力したことにより事故が発生した場合でも、被害者との関係で責任を負うのは、原則として当該AIを利用する事業者となると考えられます。現在の技術水準では生成AIのハルシネーション(誤回答)は完全には排除できないと考えられており、業務の効率化のために最新の生成AIシステムを導入したものの、当該システムへの過度な信頼が要因となって重大な事故が発生し、顧客等に対して多額の賠償義務を負ってしまう、という事態も想定されます。

そのため、事業者が自らの業務に判断補助型AIを導入・活用するにあたっては、事前にリスクの確認・評価(リスクチェック)を実施することが重要といえるでしょう。特に、いわゆる「専門業務」と評価され得るような、高度な専門性を要する業務を営む事業者においては、その重要性が一層高まると考えられます。

具体的には、AIシステムの導入を検討する段階で、対象となるAIシステムの正確な理解に努め、「何ができるのか(どこまで可能なのか) 」「何ができないのか」といった点を十分に把握した上で、当該AIシステムを利用した場合に業務上想定されるリスクケース(特にハルシネーションが発生した場合など)を洗い出しておくことが望ましいでしょう。その上で、マニュアルや社内規則の策定等を通じて、当該AIシステムを利用する従業員にリスクケースや予防策・対応策を周知したり、必要に応じて使用方法や利用範囲、用途を規制するなど、導入体制の整備を進めていくことが考えられます。

AIシステムの導入・活用にあたってお悩みの点などございましたら、お気軽に当事務所にご相談ください。